本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如若转载,请注明出处:http://www.ldbm.cn/p/132074.html

如若内容造成侵权/违法违规/事实不符,请联系编程新知网进行投诉反馈email:809451989@qq.com,一经查实,立即删除!相关文章

精彩回顾 | 迪捷软件亮相2023世界智能网联汽车大会

2023年9月24日,2023世界智能网联汽车大会(以下简称大会)在北京市圆满落幕。迪捷软件北京参展之行圆满收官。

本次大会由工业和信息化部、公安部、交通运输部、中国科学技术协会、北京市人民政府联合主办,是我国首个经国务院批准的…

口袋参谋:淘宝查宝贝排名超实用工具!99%的商家都在用!!!

对于99.99%的中小店铺来说,宝贝排名是影响店铺流量和销量的重要因素之一。想要提升店铺的流量和销量,就需要掌握宝贝排名的情况。 手动查询宝贝排名是一件费时费力的事情,而且很难做到全面和准确,这时候,宝贝查排名工…

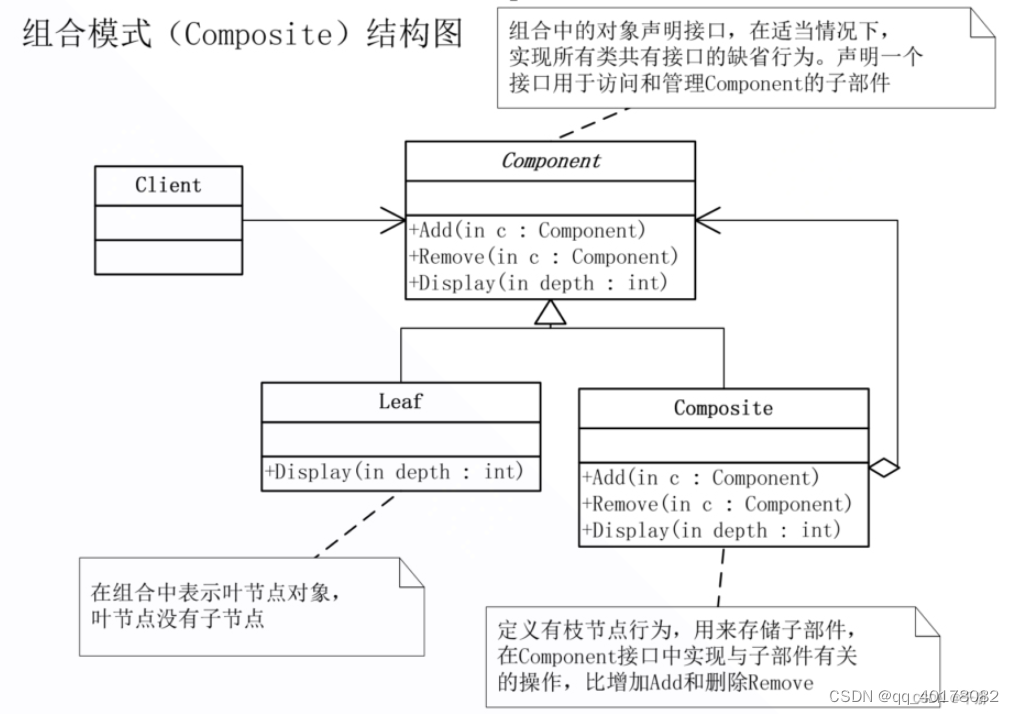

19.组合模式(Composite)

意图:将对象组成树状结构以表示“部分-整体”的层次结构,使得Client对单个对象和组合对象的使用具有一致性。 上下文:在树型结构的问题中,Client必须以不同的方式处理单个对象和组合对象。能否提供一种封装,…

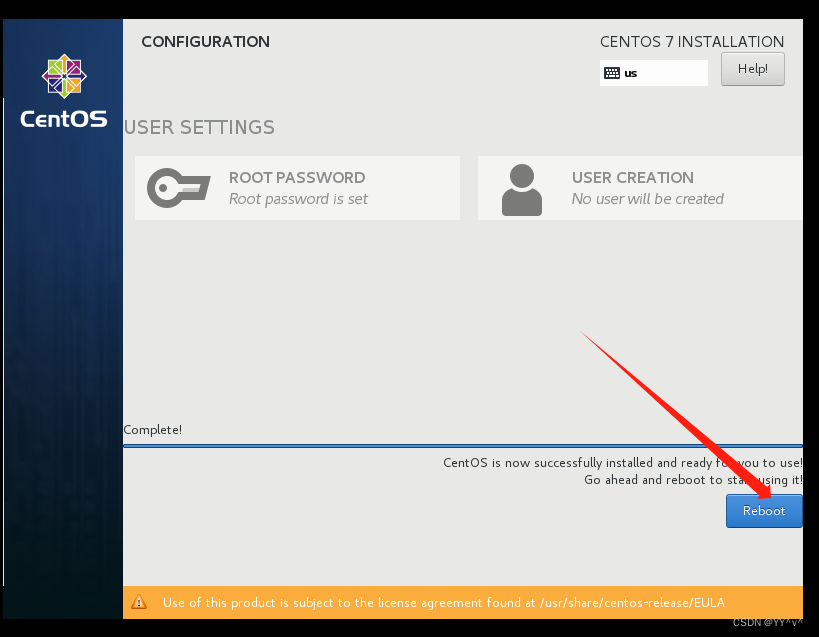

虚拟机安装CentOS 7

一、CentOS7.4下载 官网下载地址:http://vault.centos.org/

1、进入CentOS下载官网,找到CentOS7.4版本往下滑找到要下载的版本(这里我用的是7.4哈~~) 下载完成之后,由于“CentOS-7-x86_64-DVD-1708.torrent”只是一…

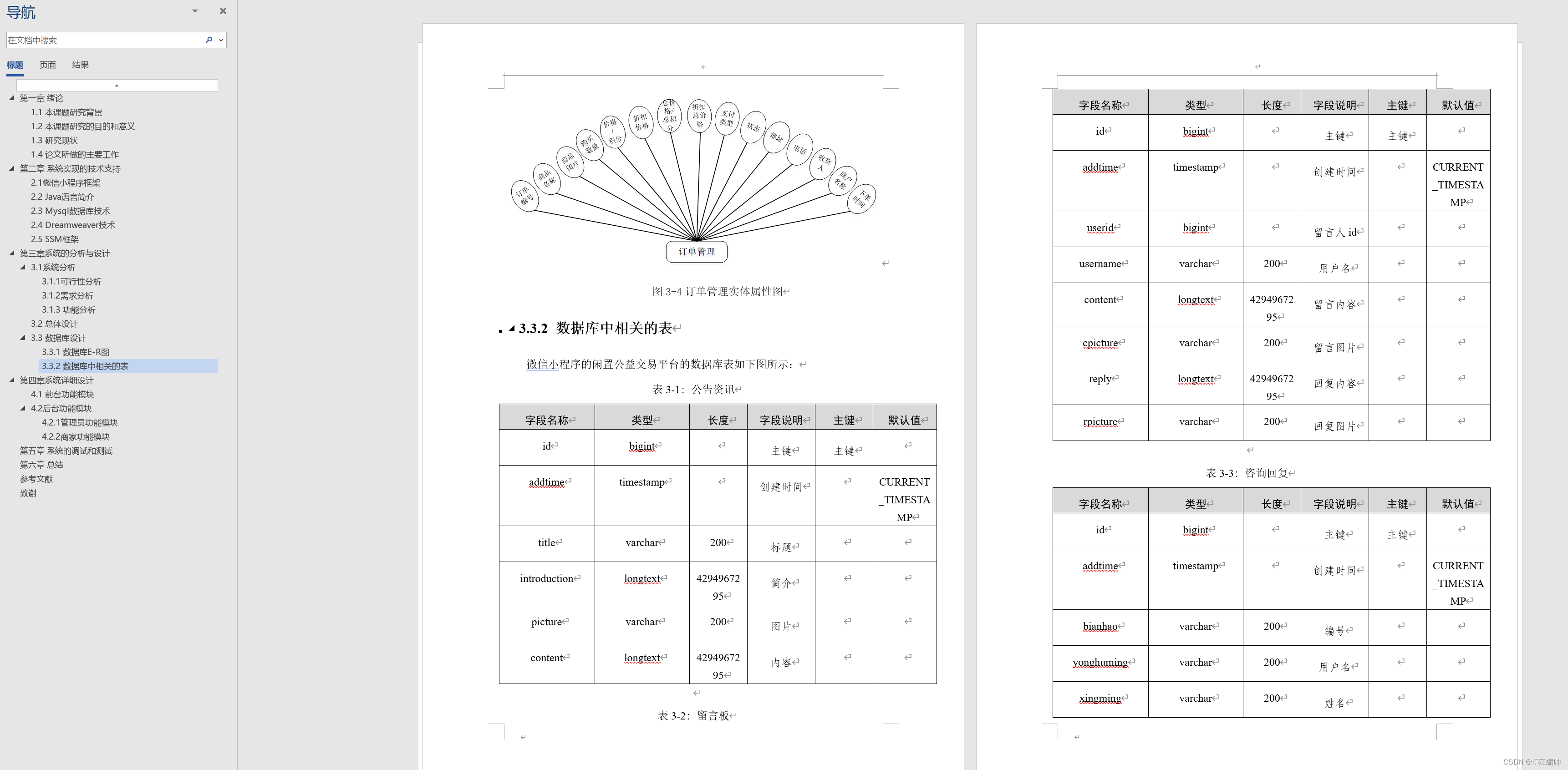

计算机毕业设计 基于微信小程序的校园商铺系统的设计与实现 Java实战项目 附源码+文档+视频讲解

博主介绍:✌从事软件开发10年之余,专注于Java技术领域、Python人工智能及数据挖掘、小程序项目开发和Android项目开发等。CSDN、掘金、华为云、InfoQ、阿里云等平台优质作者✌ 🍅文末获取源码联系🍅 👇🏻 精…

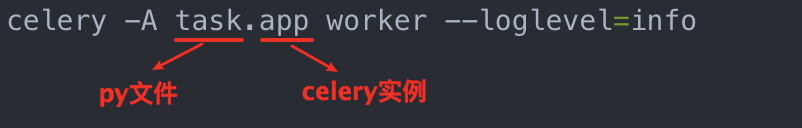

Celery结合flask完成异步任务与定时任务

Celery 常用于 web 异步任务、定时任务等。 使用 redis 作为 Celery的「消息代理 / 消息中间件」。 这里通过Flask-Mail使用qq邮箱延时发送邮件作为示例

pip install celery

pip install redis

pip install Flask-Mail1、使用flask发送邮件

使用 Flask-Mail 发送邮件需要进行…

关于ElementUI之首页导航与左侧菜单实现

目录 一.Mock

1.1.什么是Mock.js 1.2.特点

1.3.安装与配置

1.3.1. 安装mock.js

1.3.2.引入mock.js

1.4.mockjs使用

1.4.1.定义测试数据文件

1.4.2.mock拦截Ajax请求

1.4.3.界面代码优化

二.总线

2.1.是什么

2.2.前期准备

2.3.配置组件与路由关系

2.3.1. 配置组件 …

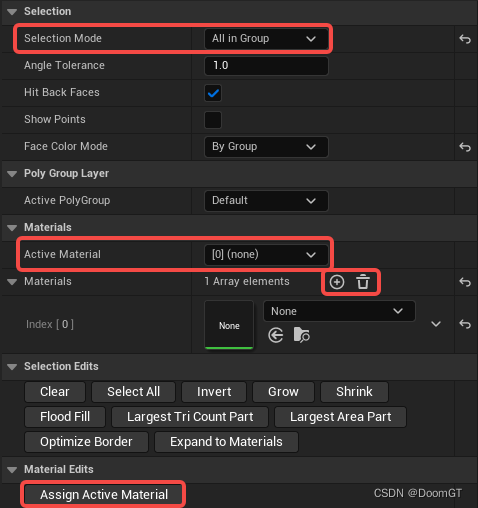

Levels - UE5中的建模相关

一些日常的笔记; 可以使用Shapes面板建立基础模型: 可以在PolyModel中继续细分模型: UE5中的建模有PolyGroups概念,可以在Attributes面板中直接编辑: 使用GrpPnt方式可以直接用笔刷设定新的PolyGroups,这样…

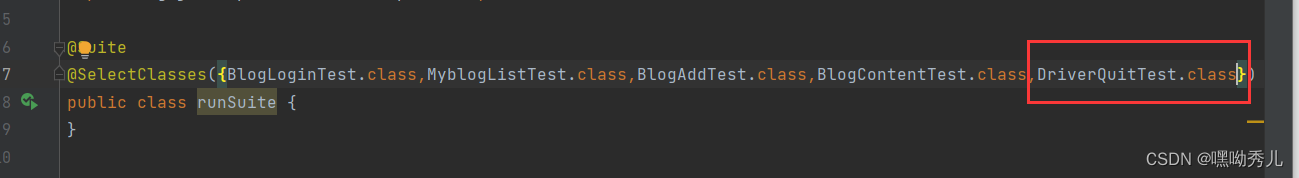

博客系统的自动化测试

本次自动化实战内容:本次测试根据博客管理系统这个项目,首先设计UI自动化测试用例,然后使用Selenium4自动化测试工具和JUnit5单元测试框架,实现web端的自动化测试。

本次项目总体实现思路:目录下有一个common包&#…

积跬步致千里 || 可视化动图展示

可视化动图展示

目前只能在 jupyter notebook 中测试成功

%matplotlib notebook

import numpy as np

import matplotlib.pyplot as plt

import timen 500

data np.random.normal(0,1,n)fig plt.figure()

ax fig.add_subplot(111)fig.show()

fig.canvas.draw()for i in ra…

c语言常见字符函数、内存函数(详讲)

前言:

其实在c语言当中是没有字符串这一概念的,不像c里面有string类型用来存放字符串。在c语言中我们只能把字符串放在字符串常量以及字符数组中。

1.常见字符串函数

1.1strlen

size_t strlen ( const char * str );作用:用来求字符串中 …

王道考研计算机组成原理

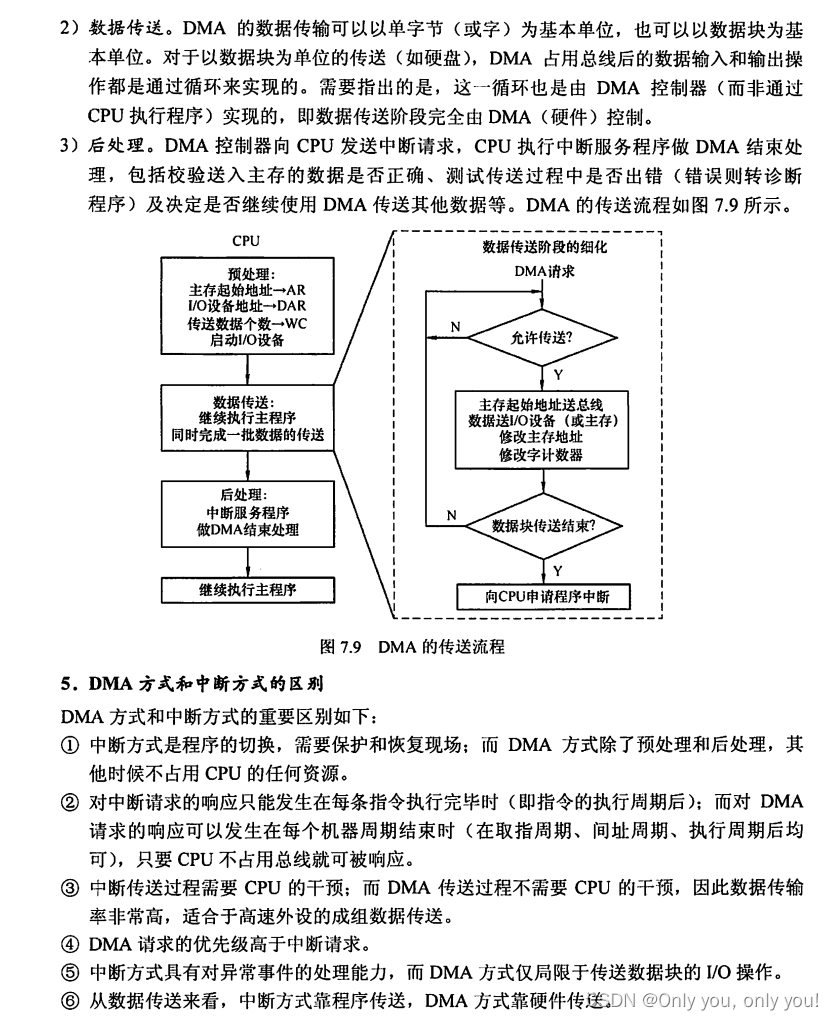

王道考研计算机组成原理 计算机系统概述计算机系统层次结构计算机的性能指标错题 数据的表示和运算数制与编码运算方法和运算电路浮点数的表示与运算 存储系统存储器概述主存储器主存储器与CPU的连接外部存储器高速缓冲存储器虚拟存储器 指令系统指令格式指令的寻址方式程序的机…

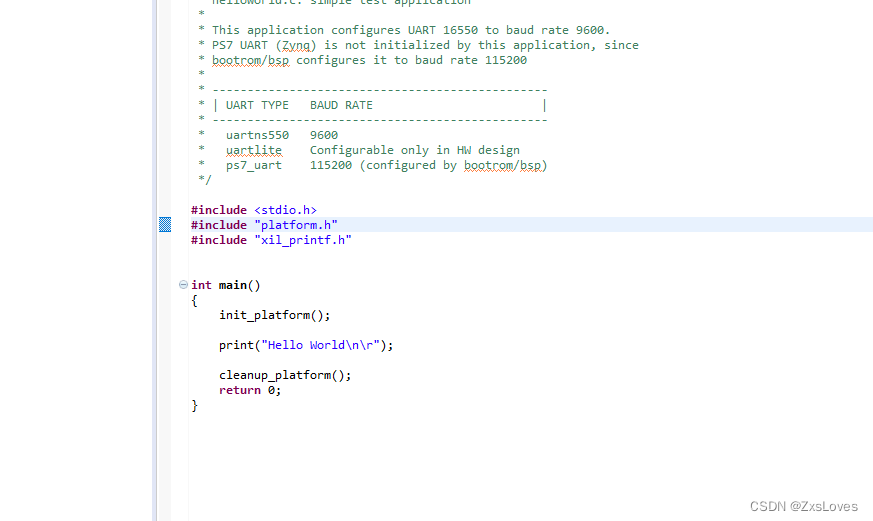

【【萌新的SOC大学习之hello_world】】

萌新的SOC大学习之hello_world

zynq本次hello world 实验需要 PS-PL Configuration 页面能够配置 PS-PL 接口,包括 AXI、HP 和 ACP 总线接口。 Peripheral IO Pins 页面可以为不同的 I/O 外设选择 MIO/EMIO 配置。 MIO Configuration 页面可以为不同的 I/O 外设具…

算法基础之差分和前缀和

差分

差分介绍 结论:差分是前缀和的逆运算 举例

一维差分

//一维前缀和 a[i]部分就是一维差分数组

s[i] s[i-1]a[i];

//一维差分

a[i] s[i]-s[i-1];二维差分

//二维前缀和 a[i][j]部分就是一维差分数组

s[i][j] s[i-1][j]s[i][j-1]-s[i-1][j-1]a[i][j];

//二…

已解决: Microservice Error: Timeout Error: Service didn‘t respond in time

🌷🍁 博主猫头虎(🐅🐾)带您 Go to New World✨🍁 🦄 博客首页:

🐅🐾猫头虎的博客🎐《面试题大全专栏》 🦕 文章图文并茂🦖…

【Java 基础篇】Java 模块化详解

Java 9引入了一项重要的功能:模块化(Module System)。模块化是一种将代码和资源封装到可重用和独立的单元中的方法,它有助于改善代码的可维护性、可重用性和安全性。本文将介绍Java模块化的基本概念、如何创建和使用模块以及一些最…

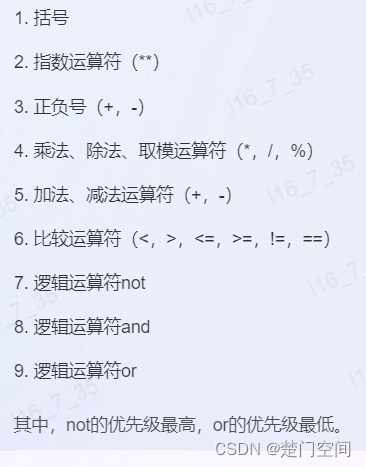

python循环判断

运算符短路逻辑python优先级 思维导图for循环 运算符

运算符含义and左边和右边同时为True,结果为Trueor左右两边其中一个为True,结果为Truenot如果操作数为True(False),结果为False(True) 短路逻辑

从左到右,只有当第一操作数的值无法确定逻辑运算的结…