本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如若转载,请注明出处:http://www.ldbm.cn/p/286538.html

如若内容造成侵权/违法违规/事实不符,请联系编程新知网进行投诉反馈email:809451989@qq.com,一经查实,立即删除!相关文章

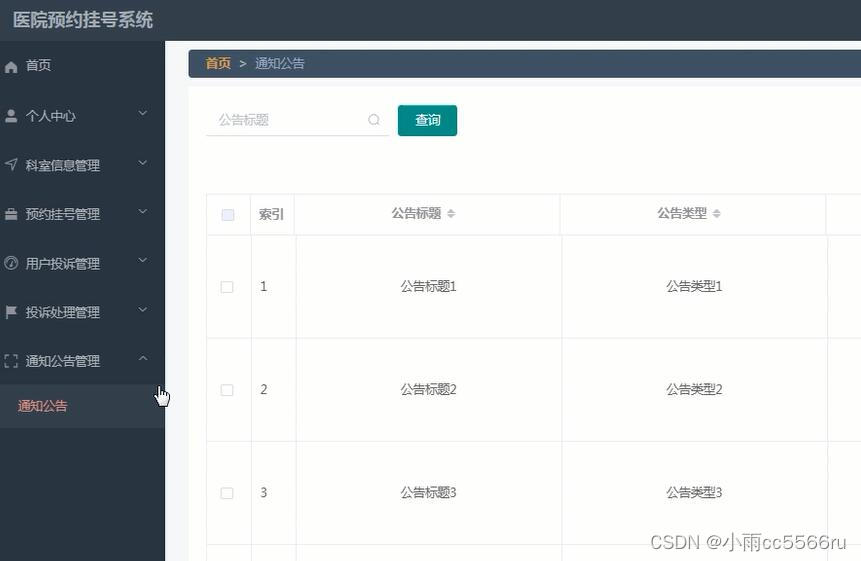

nodejs+vue+ElementUi医院预约挂号系统3e3g0

本医院预约挂号系统有管理员,医生和用户。该系统将采用B/S结构模式,使用Vue和ElementUI框架搭建前端页面,后端使用Nodejs来搭建服务器,并使用MySQL,通过axios完成前后端的交互 管理员功能有个人中心,用户管…

[Angular] 笔记 7:模块

Angular 中的模块(modules) 是代码在逻辑上的最大划分,它类似于C, C# 中的名字空间: module 可分为如下几种不同的类型: 使用模块的第一个原因是要对代码进行逻辑上的划分,第二个非常重要的原因是为了实现懒惰加载(lazy loading)&…

探索UX设计师的日常任务,赶紧看看

UX 设计师专注于产品开发的各个方面,包括设计、可用性、功能、甚至品牌和营销。他们的工作涉及用户与产品交互的整个端到端旅程,包括为产品和业务识别新的机会。

鉴于他们广泛的范围,UX 设计师根据公司和项目的要求,执行多种不同…

java定义三套场景接口方案

一、背景

在前后端分离开发的背景下,后端java开发人员现在只需要编写接口接口。特别是使用微服务开发的接口。resful风格接口。那么一般后端接口被调用有下面三种场景。一、不需要用户登录的接口调用,第二、后端管理系统接口调用(需要账号密…

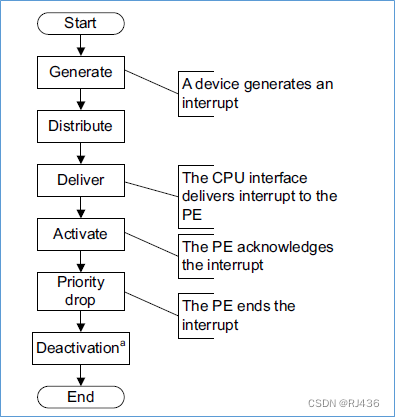

ARM GIC(四) gicv3架构基础

GICv3架构是GICv2架构的升级版,增加了很多东西。变化在于以下:

使用属性层次(affinity hierarchies),来对core进行标识,使gic支持更多的core

将cpu interface独立出来,用户可以将其设计在core…

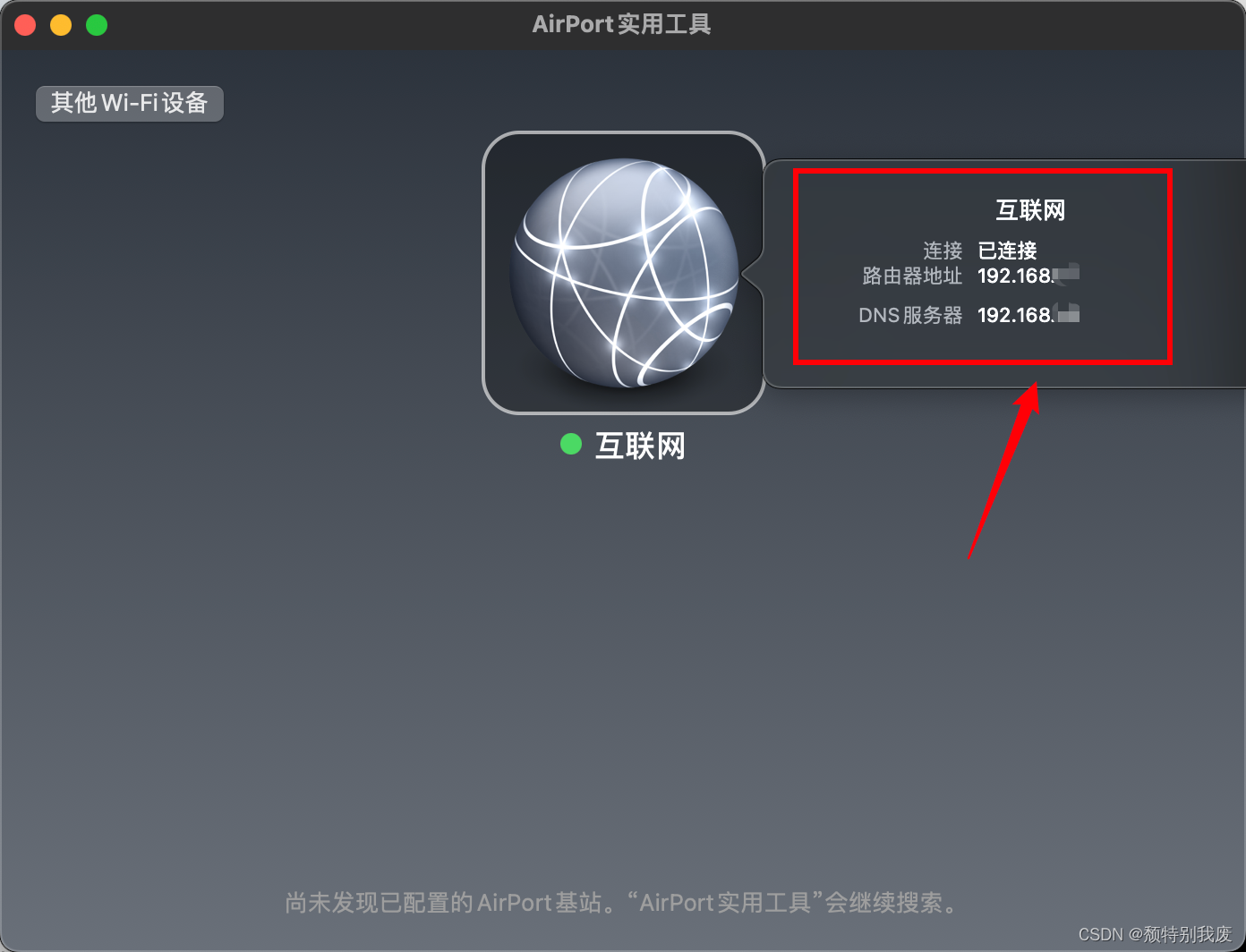

Mac查询本机ip地址

Mac系统版本和网络配置不同,可能会有一些细微差别。

一、 使用系统偏好设置

1、点击屏幕左上角的Apple图标,选择“系统偏好设置”。 2、点击“网络”。 3、 在左侧选择当前连接的网络(如Wi-Fi或以太网),在右侧界面&a…

微搭低代码密码加密存储

目录 1 加密密码2 密码存入用户表中总结 我们在用户登录注册部分,给出了用户注册的例子。但是有一个问题,密码是在数据库中明文存储的,很容易就被破解。为了提高登录的安全性,我们本次讲解一下如何解决密码的加密存储。 1 加密密码…

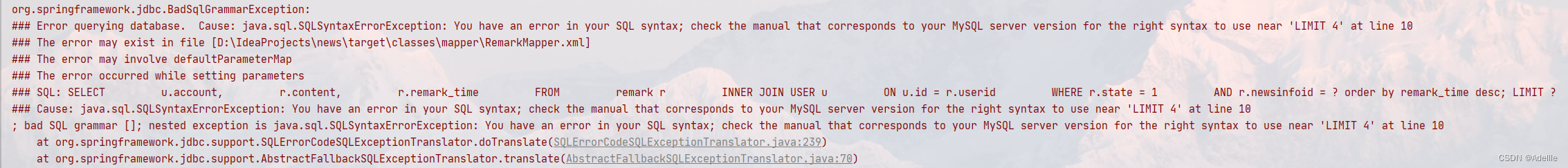

SpringBoot+vue实现评论区分页效果

当评论区含大量数据时,一次性查询速度很慢,所以使用分页,实现分页效果。

前端: <h3>评论</h3><div><div style"font-size:14px;padding:10px;" v-for"r in form.remark"><!-- …

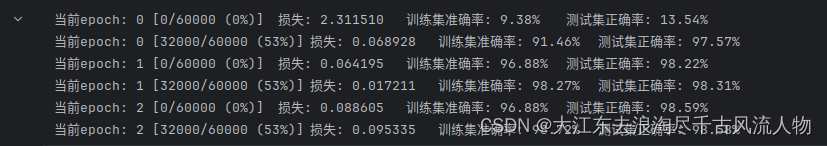

【Pytorch】学习记录分享6——PyTorch经典网络 ResNet与手写体识别

【Pytorch】学习记录分享5——PyTorch经典网络 ResNet 1. ResNet (残差网络)基础知识2. 感受野3. 手写体数字识别3. 0 数据集(训练与测试集)3. 1 数据加载3. 2 函数实现:3. 3 训练及其测试: 1. ResNet &…

Pytorch-RealSR超分模型

1.前言 RealSR 是一种基于学习的单图像超分辨率(SISR)模型,专门针对真实世界的图像。它由腾讯 AI 实验室于 2020 年提出。 RealSR 的核心创新是提出了一种新的退化模型,该模型能够更好地模拟真实世界的退化过程。该模型考虑了真实…

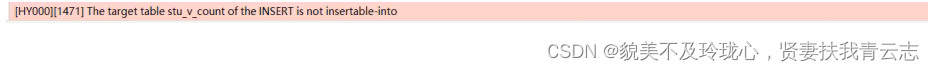

MySQL数据库 视图

目录

视图概述

语法

检查选项

视图的更新

视图作用

案例 视图概述

视图(View)是一种虚拟存在的表。视图中的数据并不在数据库中实际存在,行和列数据来自定义视图的查询中使用的表,并且是在使用视图时动态生成的。

通俗的讲,视图只保存…

Servlet-Filter 执行顺序测试

Servlet-Filter 执行顺序测试

对于 web.xml 文件注册过滤器这里就不多说了,就是谁声明的早,谁先被调用。因为在上面的过滤器信息最先被扫描到。

模型抽象

为了便于在实践中使用,结合部分底层原理,我们可以对 Filter 链的执行做…

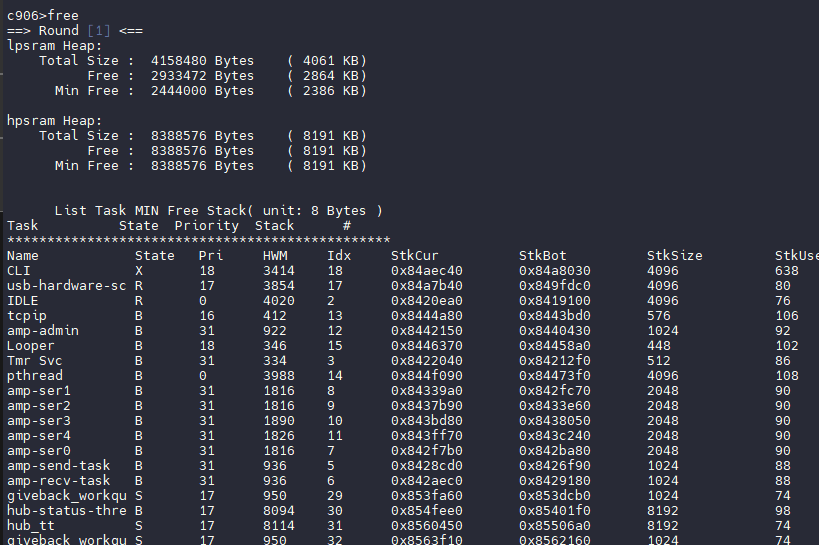

DshanMCU-R128s2启动与资源划分

启动与资源划分

下面简单介绍一下 R128 方案的资源划分与启动流程。

资源划分

CPU 资源划分

这只是默认配置方案,CPU 资源划分可以按照需求任意修改

CPU功能说明M33控制核。运行 WI-FI/BT 固件、协议栈、驱动、休眠唤醒、安全启动、安全控制C906应用核。运行大…

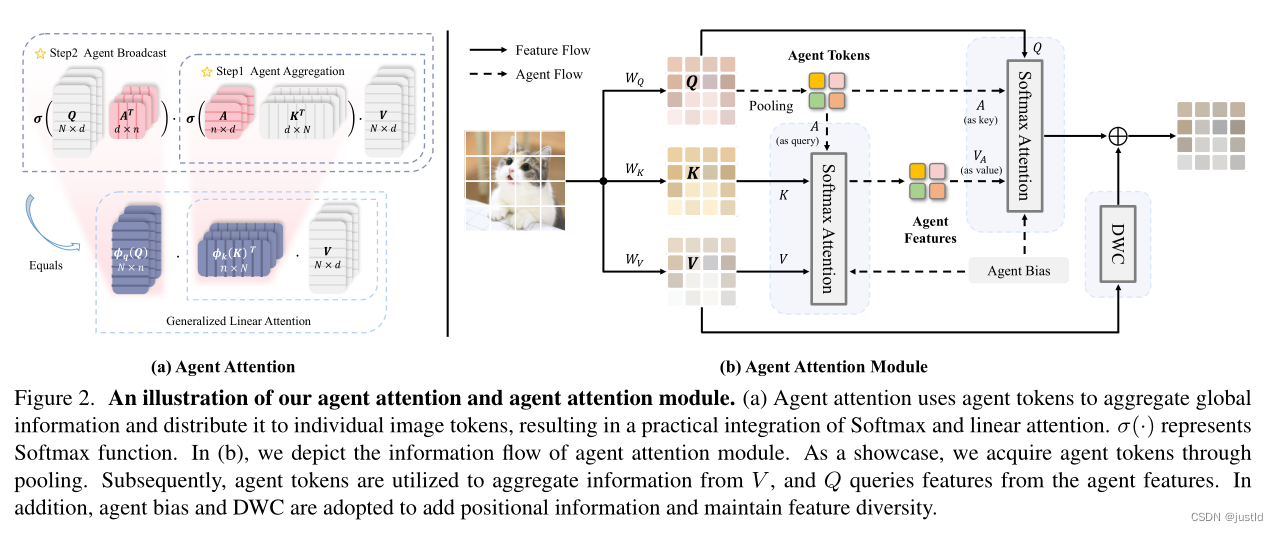

【深度学习】注意力机制(七)Agent Attention

本文介绍Agent Attention注意力机制,Transformer中的Attention模块可以提取全局语义信息,但是计算量太大,Agent Attention是一种计算非常有效的Attention模块。

论文:Agent Attention: On the Integration of Softmax and Linear…

到底需要会那些技能?才算一个5年经验合格的软件测试工程师

一:经历讲解

微软外包自动化测试两年,而后转入互联网公司做移动端自动化测试一年,经历了入行时的迷茫,而后的笃定,转入移动后对自身定位和价值的怀疑,继而对自动化测试的重新认识,职场三年&…

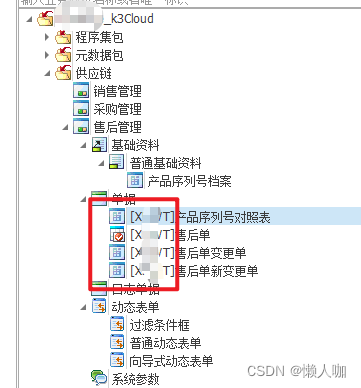

金蝶云星空执行部署包后业务对象会被标记上部署包的开发码

文章目录 金蝶云星空执行部署包后业务对象会被标记上部署包的开发码 金蝶云星空执行部署包后业务对象会被标记上部署包的开发码 会被标记成开发码的业务对象包括以下: 新增的业务对象,扩展的业务对象

--查询二开的元数据打包 FPACKAGEID不为空ÿ…

C# 创建MVC项目+Layui框架

目录

1、创建MVC

2、下载Layui

3、修改模板页

3.1 修改_Layout.cshtml页面

3.2创建侧边导航-BaseController控制器

3.3将控制器原本引用的 Controller改为BaseController 1、创建MVC 2、下载Layui

地址:Layui - 极简模块化前端 UI 组件库(官方文档) 将文件…

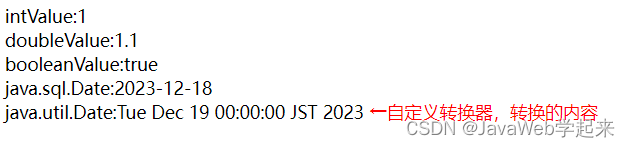

重温经典struts1之自定义类型转换器及注册的两种方式(Servlet,PlugIn)

提示:文章写完后,目录可以自动生成,如何生成可参考右边的帮助文档 前言

Struts的ActionServlet接收用户在浏览器发送的请求,并将用户输入的数据,按照FormBean中定义的数据类型,赋值给FormBean中每个变量&a…

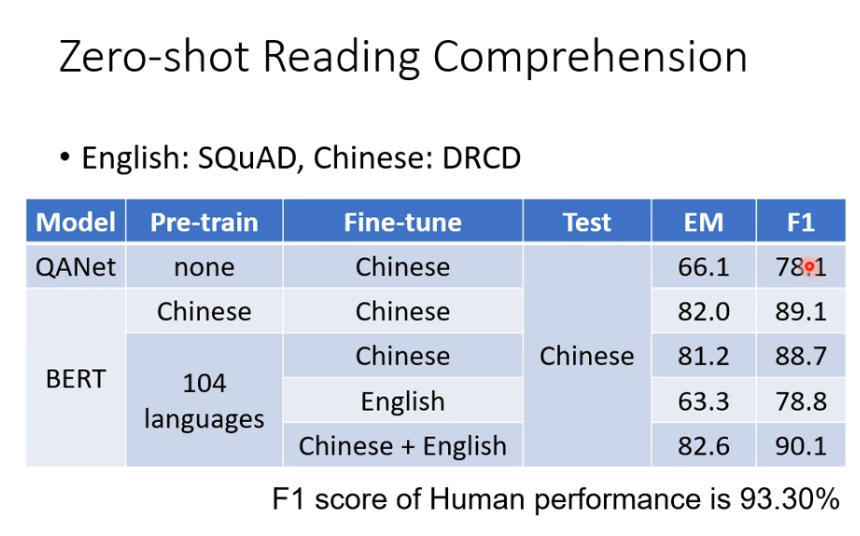

P73 bert奇闻

同一个字,前后接的不同,词汇的意思不同,通过bert 之后输出的向量也不一样。 bert 输出后的向量包含上下文的信息。 比如 吃苹果 和苹果电脑中的 果,向量不一样。 DNA 分类 把DNA 的 A T C G 用 we you he she 表示,然…

![[Angular] 笔记 7:模块](https://img-blog.csdnimg.cn/direct/4f2b7a2d951f45d4983f71d89de906f2.png)