本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如若转载,请注明出处:http://www.ldbm.cn/p/312212.html

如若内容造成侵权/违法违规/事实不符,请联系编程新知网进行投诉反馈email:809451989@qq.com,一经查实,立即删除!相关文章

6.2 声音编辑工具GoldWave5简介(7)

6.2.5其它常用功能

1.高低通

把录制的语音和背景音乐融合在一起时,可能会出现背景音乐音量过大,语音音量过小的现象,这时可以选择“低通”将背景音乐的音量降低一些。

(1)选择【效果】|【波波器】|【低通/高通】命令࿰…

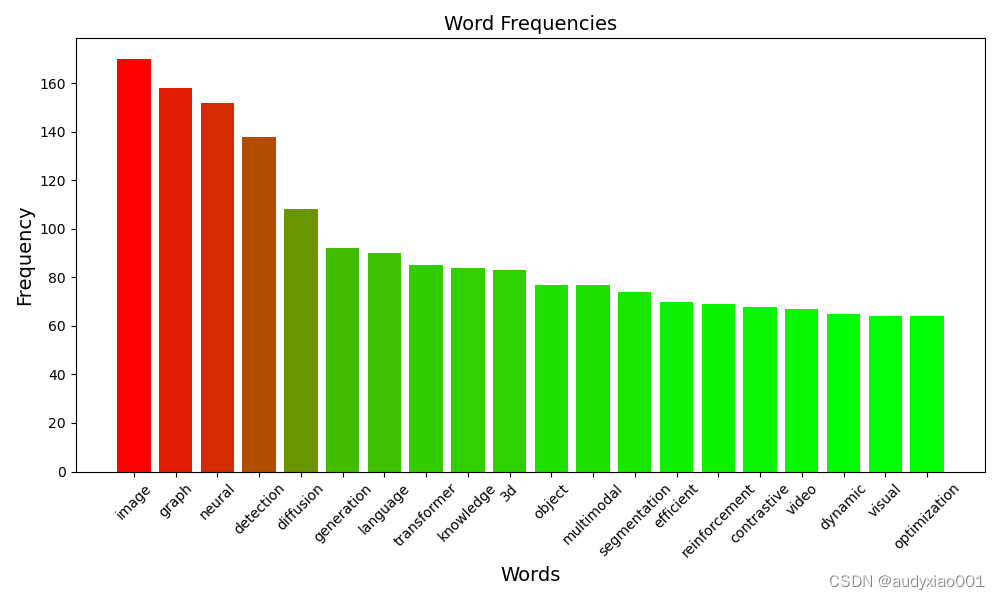

从AAAI 2024看人工智能研究的最新热点

图 1 由AAAI 2024论文列表生成的词云

AAAI会议作为全球AI领域的顶级学术盛会,被中国计算机学会(CCF)评为A类会议。AAAI2024的会议论文投稿量达到了历史新高,主赛道收到了12100篇投稿论文,9862篇论文经过严格评审后共有…

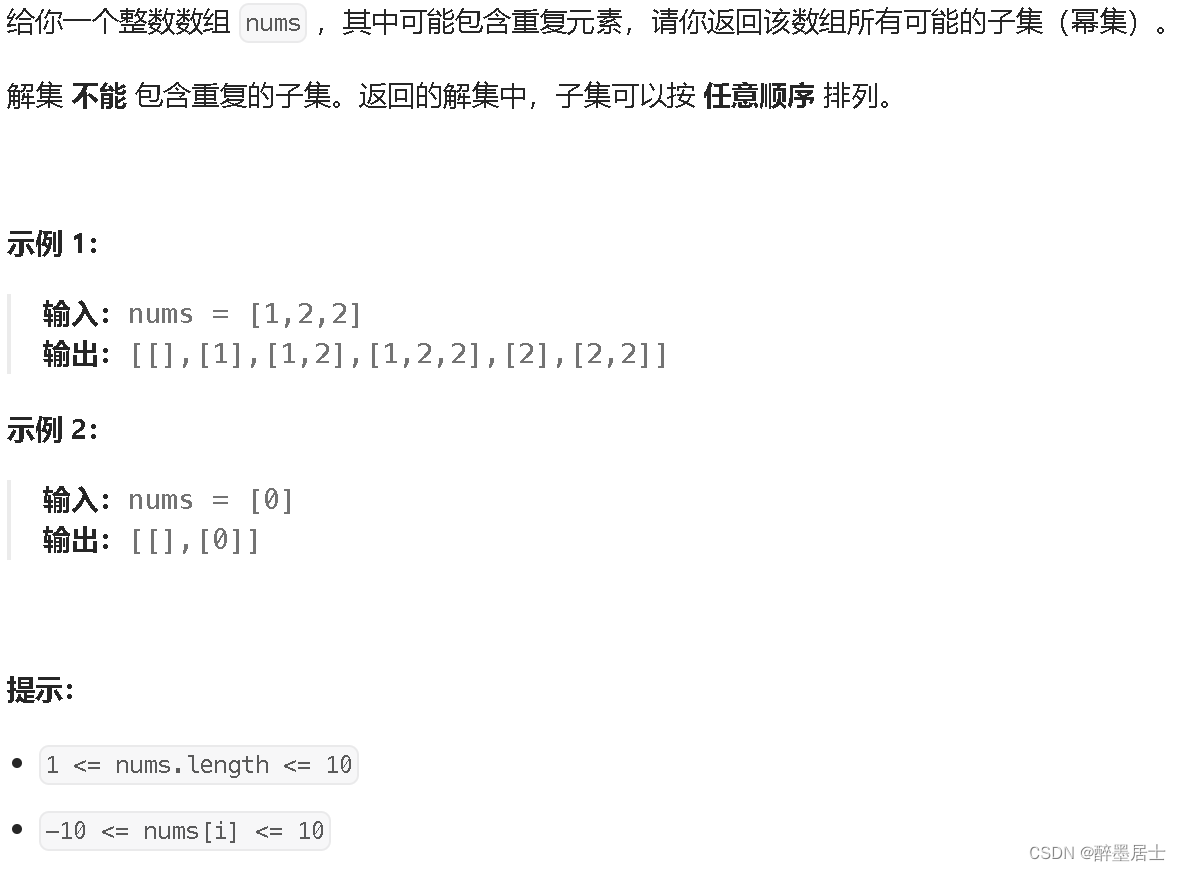

LeetCode讲解篇之90. 子集 II

文章目录 题目描述题解思路题解代码 题目描述 题解思路

初始化一个变量start表示当前从哪里开始遍历nums

搜索过程的数字组合加入结果集

从start开始遍历nums

如果当前元素和前一个元素相等,前一个元素没被使用,则触发剪枝去重操作,跳过当…

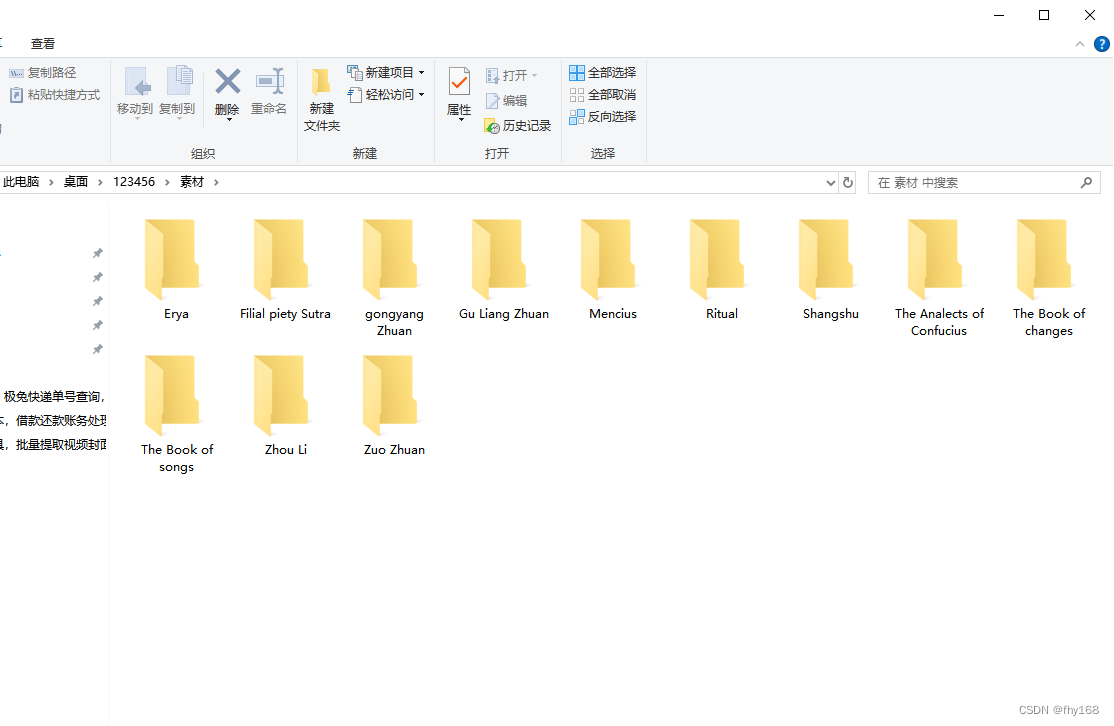

一键批量翻译,文件夹名称翻译器

文件夹名称往往是我们初步了解文件内容的重要窗口。有时,为了更好地与国际合作伙伴交流或是管理个人文件,我们需要对文件夹名称进行翻译。传统的逐一修改方法既费时又费力,还要借助翻译工具。现在有了【文件批量改名高手】,上面的…

【GitHub项目推荐--学算法】【转载】

不想做低级码农,不想成为前端抠图达人或是后台「增删改查」小王子?那你可能需要好好复习下算法与数据结构。 想成为算法工程师,基础知识是绕不开的大山。这次要推荐的项目是数据结构与算法的开源项目集,覆盖多种主流语言ÿ…

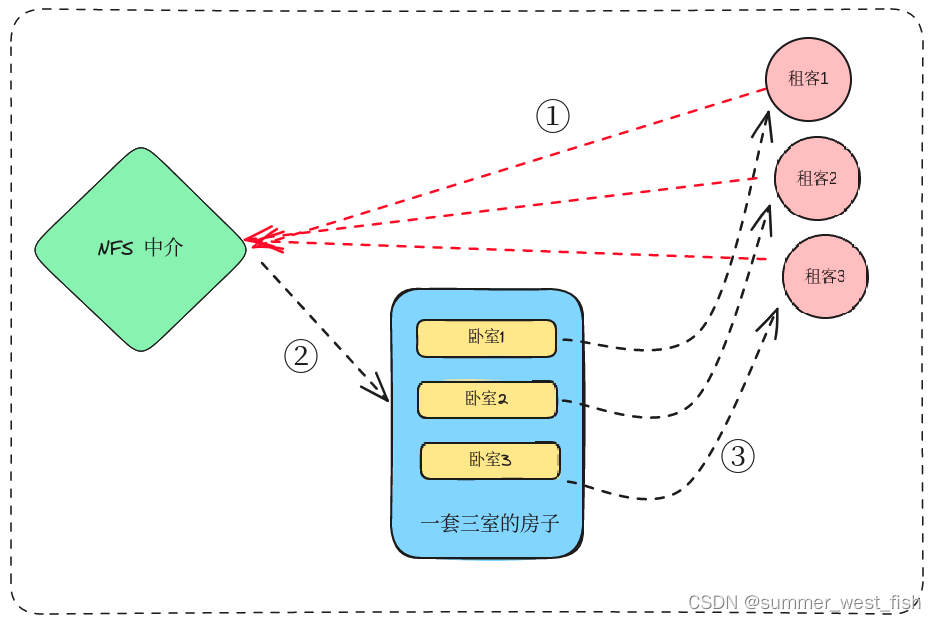

K8S中SC、PV、PVC的理解

存储类(StorageClass)定义了持久卷声明(PersistentVolumeClaim)所需的属性和行为,而持久卷(PersistentVolume)是实际的存储资源,持久卷声明(PersistentVolumeClaim&#…

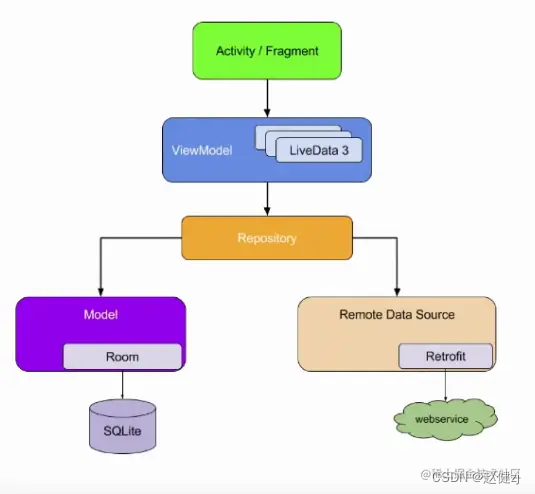

2024安卓岗位面试题总结

文章目录 数据结构ArrayListLinkedListHashMapJava7 HashMapJava8 HashMap ThreadLocalSparseArrayJava 中单例模式Java中生产者与消费者模式 高级UI面试题汇总1. View的绘制原理2. View,WindowManagerGlobal,WindowManagerService之间的关系3. requestLayout和invalidate区别4…

YOLOv7独家原创改进:多层次特征融合(SDI)结合PConv、DualConv、GSConv,实现二次创新 | UNet v2最新论文

💡💡💡本文独家改进:多层次特征融合(SDI)高效结合DualConv、PConv、GSConv等实现二次创新

1)替代原始的Concat; 收录YOLOv7原创自研

https://blog.csdn.net/m0_63774211/category_12511937.html

💡💡💡全网独家首发创新(原创),适合paper !!!

💡💡…

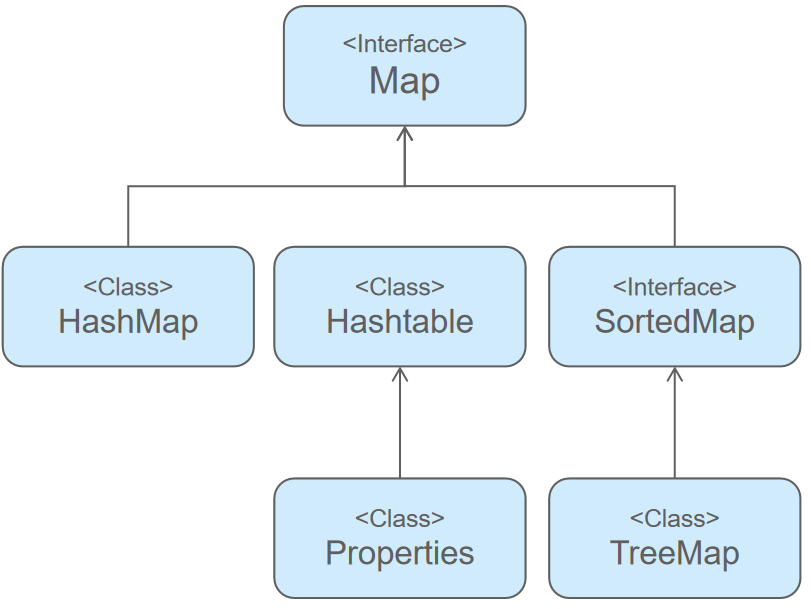

从零学Java Map集合

Java Map集合 文章目录 Java Map集合1 Map 结构2 Map 父接口2.1 Map接口的特点2.2 常用方法 3 Map集合的实现类3.1 HashMap【重点】3.2 LinkedHashMap3.3 TreeMap3.4 Hashtable(了解)3.5 Properties 属性集合 4 HashMap 源码分析 1 Map 结构

概念: 将键…

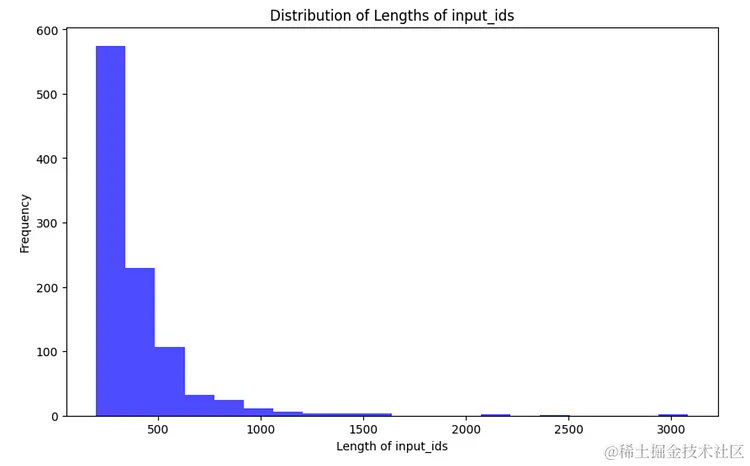

MoE模型性能还能更上一层楼?一次QLoRA微调实践

Fine-Tuning Mixtral 8x7B with QLoRA:Enhancing Model Performance 🚀 编者按:最近,混合专家(Mixture of Experts,MoE)这种模型设计策略展现出了卓越的语言理解能力,如何在此基础上进一步提升 MoE 模型的性能成为业界…

《BackTrader量化交易图解》第8章:plot 绘制金融图

文章目录 8. plot 绘制金融图8.1 金融分析曲线8.2 多曲线金融指标8.3 Observers 观测子模块8.4 plot 绘图函数的常用参数8.5 买卖点符号和色彩风格8.6 vol 成交参数8.7 多图拼接模式8.8 绘制 HA 平均 K 线图 8. plot 绘制金融图

8.1 金融分析曲线

BackTrader内置的plot绘图函…

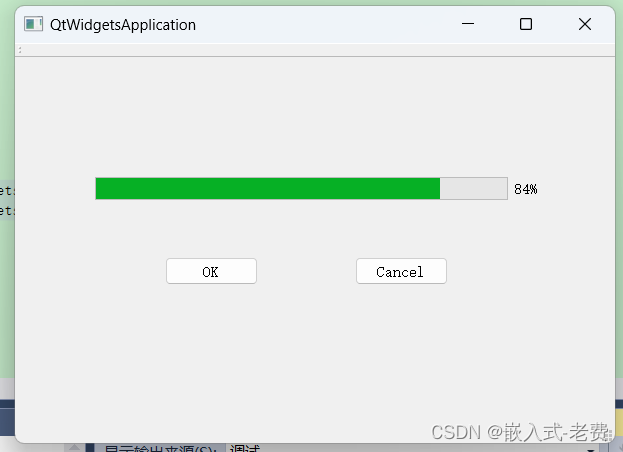

QT上位机开发(进度条操作)

【 声明:版权所有,欢迎转载,请勿用于商业用途。 联系信箱:feixiaoxing 163.com】 进度条是一个比较常见的控件。如果某个操作需要很长的时间才能完成,那么这个时候最好有一个进度条提示,这样比较容易平复一…

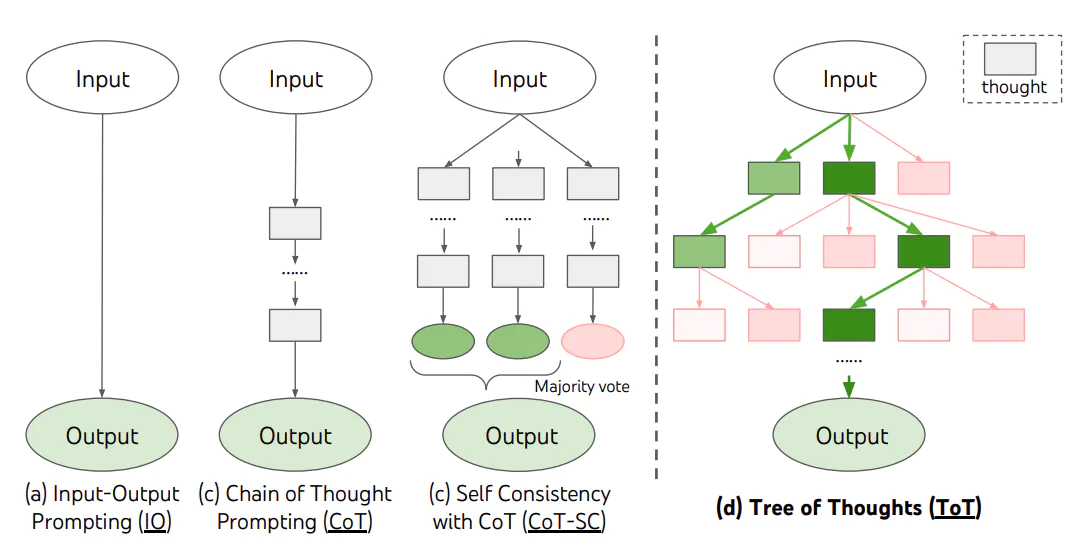

【LangChain学习之旅】—(6) 提示工程(下):用思维链和思维树提升模型思考质量

【LangChain学习之旅】—(6) 提示工程(下):用思维链和思维树提升模型思考质量 什么是 Chain of ThoughtFew-Shot CoTZero-Shot CoTChain of Thought 实战CoT 的模板设计程序的完整框架Tree of Thought总结 Reference&a…

《ORANGE’S:一个操作系统的实现》读书笔记(三十)文件系统(五)

上一篇文章记录了如何进行文件的创建,那么本篇文章要记录的事情就是如何在创建的文件中进行读写操作,毕竟文件是要操作才有意义的。

读写文件

由于我们使用“一次分配,终身使用”的扇区分配策略,所以文件读写变得非常容易&#…

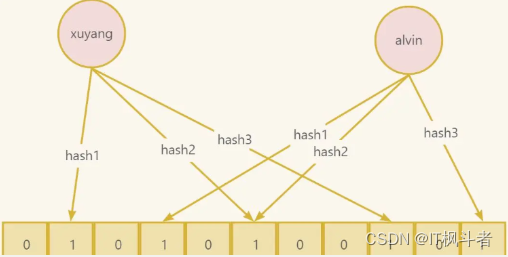

面试官问,如何在十亿级别用户中检查用户名是否存在?

面试官问,如何在十亿级别用户中检查用户名是否存在?

前言

不知道大家有没有留意过,在使用一些app注册的时候,提示你用户名已经被占用了,需要更换一个,这是如何实现的呢?你可能想这不是很简单吗…

Python 中的字符串分割函数 split() 详解

更多Python学习内容:ipengtao.com 在 Python 编程中,处理字符串是一项常见的任务。字符串分割是其中的一个常见操作,而 Python 提供了强大的 split() 函数,用于将字符串拆分成多个部分。本文将详细介绍 split() 函数的用法、参数和…

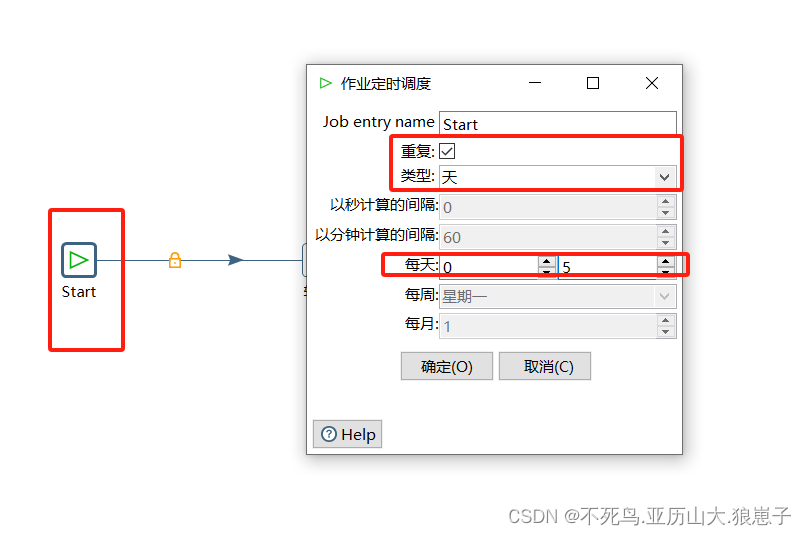

FineBI实战项目一(3):Kettle实现ETL到数据仓库

目前,finebi_shop_bi 中是没有任何数据的,是一个空的数据库。而后续我们的所有数据分析都将在该数据库中进行。我们第一件事情就是要将 「finebi_shop」数据库中的所有表抽取到「finebi_shop_bi」数据库中。要抽取并装载数据到「finebi_shop_bi」中&…

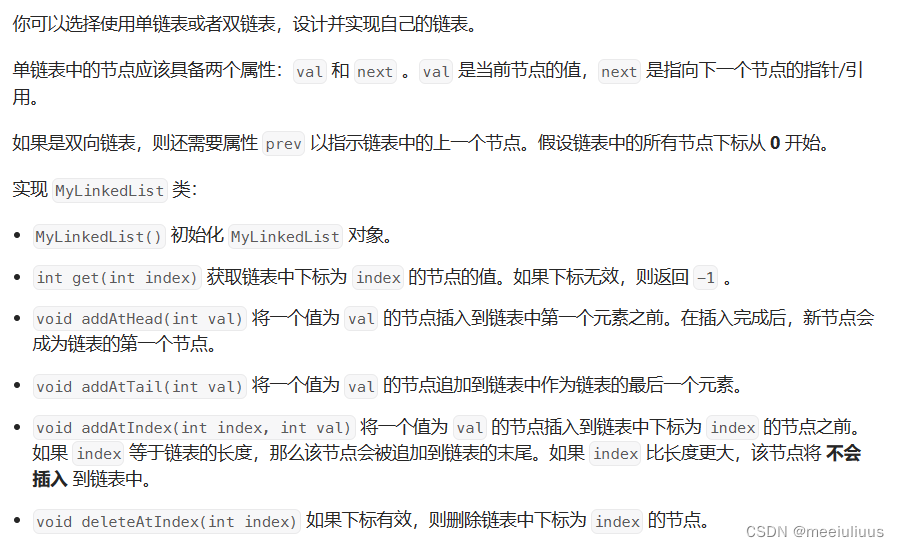

代码随想录 Leetcode707. 设计链表

题目: 代码(首刷看解析 2024年1月11日):

class MyLinkedList {

private:struct ListNode{int val;ListNode* next;ListNode(int val):val(val),next(nullptr){}};int size;ListNode* dummyHead;

public:MyLinkedList() {dummyHead new List…

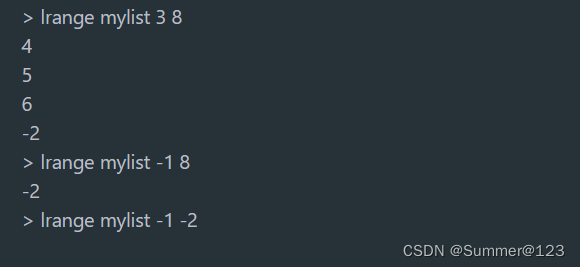

Redis命令 - Lists命令组常用命令

先创建一个 key 叫做 mylist,mylist存一个list。

list数据类型底层是一个链表。先进后出,后进先出。

命令中的L(Left)、R(Right)代表链表的头部L(下标0的位置)和尾部R(…

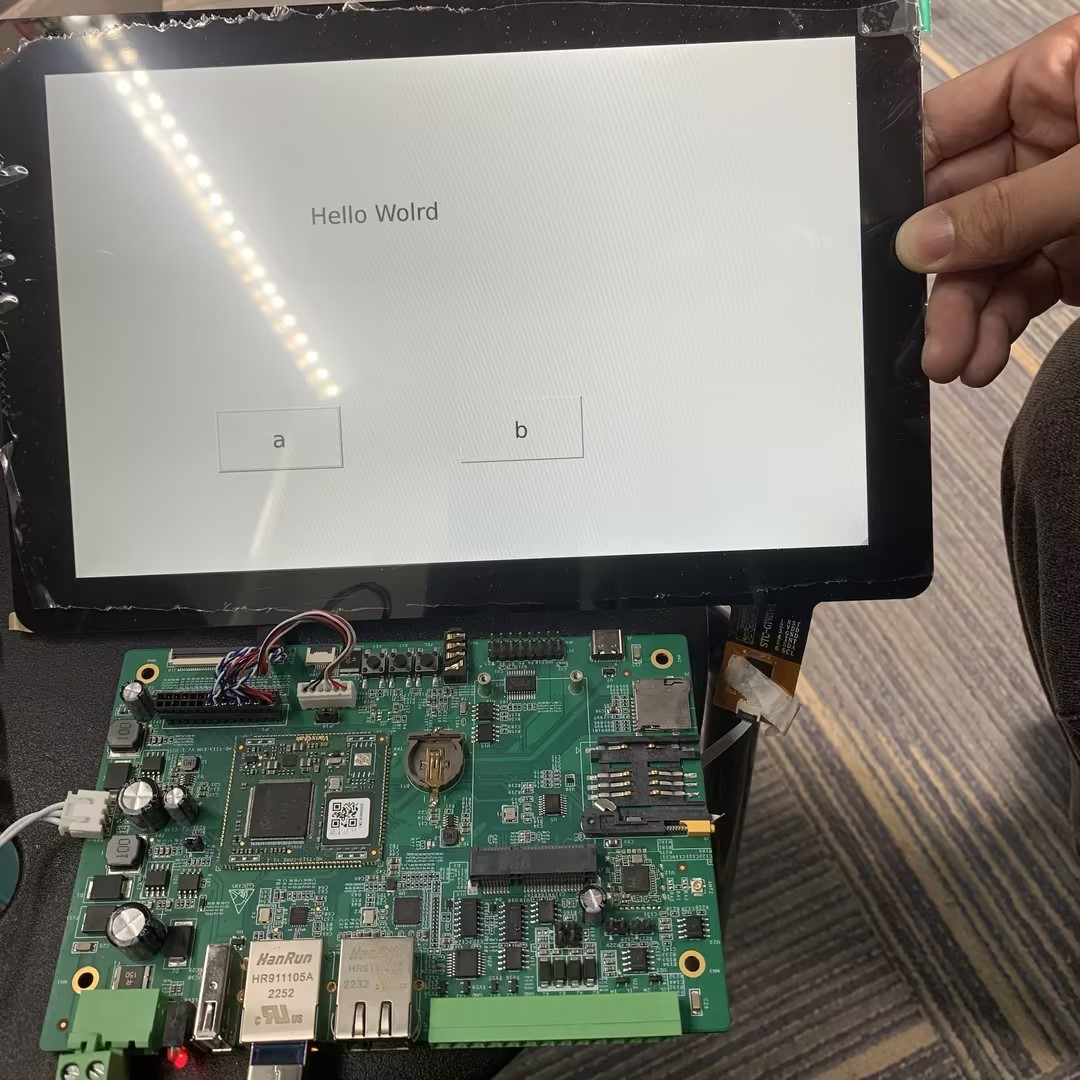

全志T113开发板Qt远程调试

1引言 通常情况下工程师在调试Qt程序时,需要频繁制作镜像烧录到核心板来测试Qt程序是否完善,这样的操作既费时又费力。这时我们可以通过QtCreator设备功能,定义设备后,在x86_64虚拟机上交叉编译qt程序,将程序远程部署到…