本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如若转载,请注明出处:http://www.ldbm.cn/p/465885.html

如若内容造成侵权/违法违规/事实不符,请联系编程新知网进行投诉反馈email:809451989@qq.com,一经查实,立即删除!相关文章

LabVIEW断路器检测系统

随着电网技术的快速发展,对电力系统的可靠性和安全性要求不断提高,塑壳断路器作为关键的保护设备,其出厂前的检测非常重要。开发了一种基于LabVIEW软件平台开发的塑壳断路器智能脱扣器检测系统,该系统能够有效提高检测的自动化水平…

GPT系列模型简要概述

GPT-1:(0.117B参数量,0.8B words预训练数据) 动机: 在RNN和Transformer之间,选择了后者。 和《All your need is Attention》翻译模型的Encoder-Decoder架构相比,只保留Decoder,因此去掉了Cross…

【Canvas与图标】乡土风金属铝边立方红黄底黑字图像处理图标

【成图】

120*120图标: 大小图: 【代码】 <!DOCTYPE html>

<html lang"utf-8">

<meta http-equiv"Content-Type" content"text/html; charsetutf-8"/>

<head><title>金属铝边立方红黄底黑…

Linux入门攻坚——40、Linux集群系统入门-lvs(1)

Cluster,集群,为了解决某个特定问题将多台计算机组合起来形成的单个系统。 这个单个集群系统可以扩展,系统扩展的方式:scale up,向上扩展,更换更好的主机;scale out,向外扩展&…

【C#】NET 9中LINQ的新特性-CountBy

前言 在 .NET 中,使用 LINQ 对元素进行分组并计算它们的出现次数时,需要通过两个步步骤。首先,使用 GroupBy方法根据特定键对元素进行分类。然后,再计算每个组元素包含个数。而随着 .NET 9 版本发布,引入了一些新特性。其中 LINQ 引入了一种新的方法 CountBy,本文一起来了…

uniapp使用百度图表echarts的简要过程记录

uniapp中使用百度图表echarts的pie饼图简要过程记录

比如要实现如下图的功能: 1.安装echarts,在项目目录中运行

npm i echarts

2.模板代码: <div id"chartbox1" style"width: 100%;height:100%;min-height:200px;"></di…

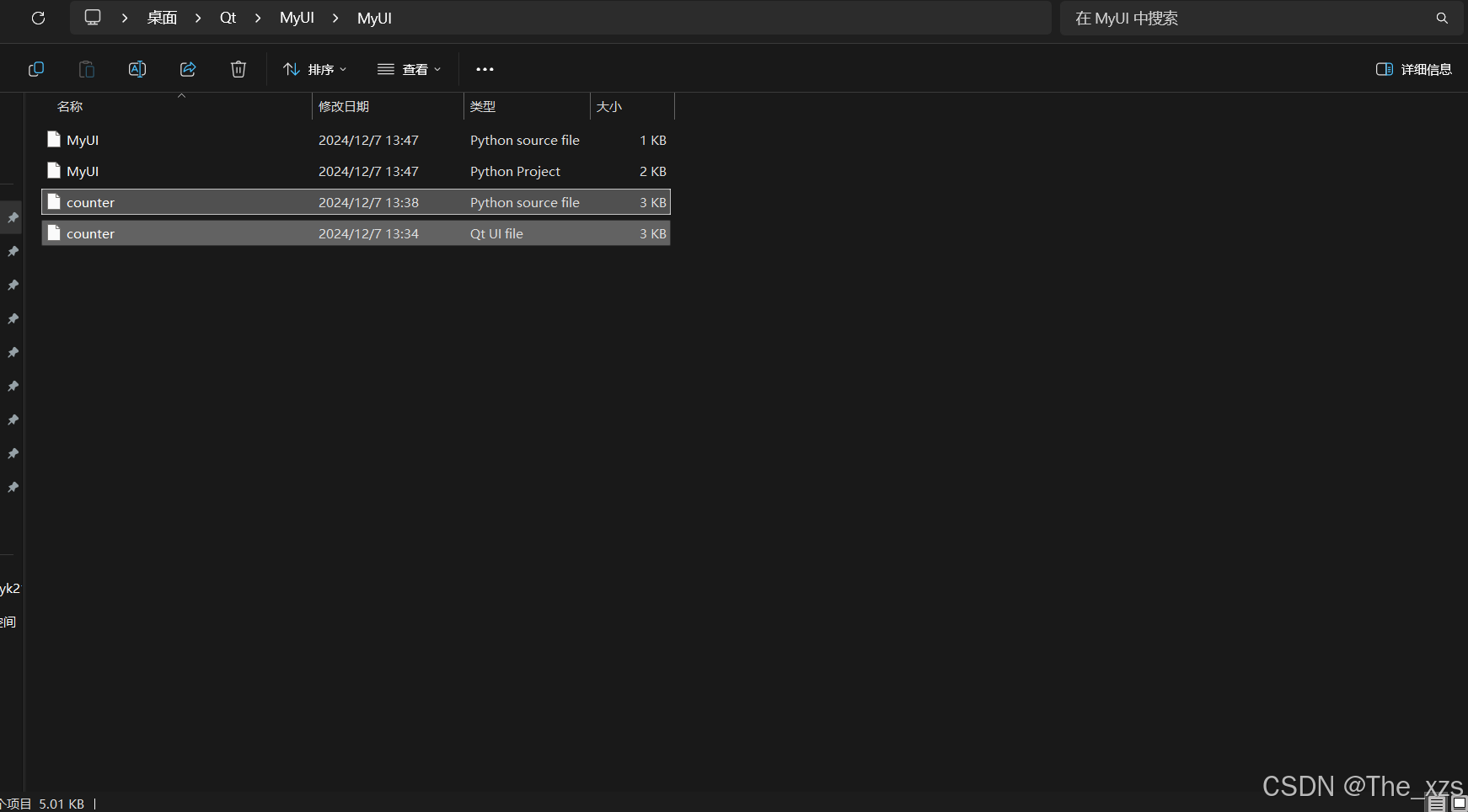

【PyQt5教程 一】Qt Designer 安装及其使用方法说明,附程序源码

目录

一、PyQt5介绍:

(1)PyQt简介:

(2)PyQt API:

(3)支持的环境:

(4)安装:

(5)配置环境变量…

一般在写SQL时需要注意哪些问题,可以提高查询的效率?

很多人写SQL按照自己喜好,没有规则意识,这对于自主查询影响不大,你爱怎么搞就怎么搞,一旦涉及到提交任务或团队共享,就不能乱写了,会浪费资源影响到开发效率,严重的甚至会服务器瘫痪。 提几个关…

二叉排序树的定义以及相关操作

二叉排序树:又称二叉查找树(BST,Binary Search Tree)

二叉排序树的性质:左子树节点值 < 根节点值 < 右子树节点值

所以 对一棵二叉排序树进行中序遍历,会得到一个递增的序列

定义二叉排序树的结点…

多级IIR滤波效果(BIQUAD),system verilog验证

MATLAB生成IIR系数

采用率1k,截止频率30hz,Matlab生成6阶对应的biquad3级系数

Verilog测试代码

// fs1khz,fc30hz

initial beginreal Sig_Orig, Noise_white, Mix_sig;real fs 1000;Int T 1; //周期int N T*fs; //1s的采样点数// 数组声明…

C++的一些经典算法

以下是C的一些经典算法:

一、排序算法

冒泡排序(Bubble Sort) 原理: 它重复地走访过要排序的数列,一次比较两个元素,如果它们的顺序错误就把它们交换过来。走访数列的工作是重复地进行直到没有再需要交换…

力扣面试150 环形子数组的最大和 循环数组 逆向思维

Problem: 918. 环形子数组的最大和 👨🏫 参考题解 ⏰ 时间复杂度: O ( n ) O(n) O(n) 🌎 空间复杂度: O ( 1 ) O(1) O(1)

class Solution {public int maxSubarraySumCircular(int[] nums) {int maxSum Integer.M…

PowerShell install 一键部署postgres17

postgres 前言

PostgreSQL 是一个功能强大的开源对象关系数据库系统,拥有超过 35 年的积极开发经验 这为其赢得了可靠性、功能稳健性和性能的良好声誉。 通过官方文档可以找到大量描述如何安装和使用 PostgreSQL 的信息。 开源社区提供了许多有用的地方来熟悉PostgreSQL, 了…

MongoDB分片集群搭建及扩容

分片集群搭建及扩容

整体架构 环境准备

3台Linux虚拟机,准备MongoDB环境,配置环境变量。一定要版本一致(重点),当前使用 version4.4.9 配置域名解析

在3台虚拟机上执行以下命令,注意替换实际 IP 地址

e…

从差分电容到多轴测量:解读 BendLabs 柔性弯曲传感器核心技术

BendLabs是一家技术公司,致力于通过灵活的软传感解决方案将运动测量和理解带给世界。BendLabs柔性弯曲传感器由医用级有机硅制成,能够满足精确、多轴、柔软、灵活的传感需求。BendLabs柔性弯曲传感器采用差分电容原理,具有高精度、低功耗、无…

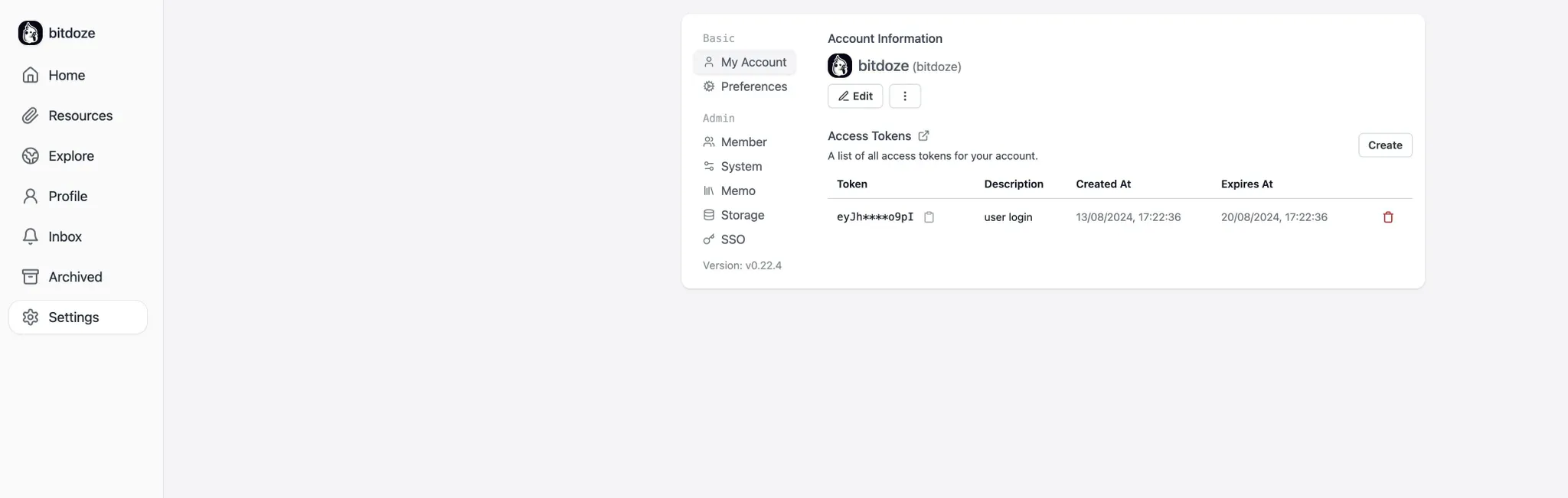

如何使用 Docker Compose 安装 Memos 自托管笔记应用

简介

Memos是一个自托管的开源笔记应用程序,专为个人组织和信息管理而设计。它允许用户高效地创建、存储和管理笔记,提供如Markdown支持、用户友好的界面和注重隐私的设计等功能。Memos可以在各种平台上运行,但使用Docker Compose可以简化部…

完美解决Qt Qml窗口全屏软键盘遮挡不显示

1、前提

说明:我使用的是第三方软键盘 QVirtualKeyboard

QVirtualKeyboard: Qt5虚拟键盘支持中英文,仿qt官方的virtualkeyboard模块,但使用QWidget实现。 - Gitee.com

由于参考了几篇文章尝试但没有效果,链接如下:

文章一:可能…

【成功解决】:VS2019(Visual Studio 2019)遇到E2870问题:此配置中不支持 128 位浮点类型

起因:项目中需要用json来操作数据,就引了cJSON库(cJSON.h和cJSON.c文件),但是发现编译报错如下 E2870 此配置中不支持 128 位浮点类型 test0 ...\usr\include\x86_64-linux-gnu\bits\floatn.h 75 然后先新建了个工程来检查问题(甚至在这之前还以为是cjson…

Mybatis框架进阶(标签)

1. <if>标签

DROP DATABASE IF EXISTS mybatis_test;

CREATE DATABASE mybatis_test DEFAULT CHARACTER SET utf8mb4;

use mybatis_test;DROP TABLE IF EXISTS user_info;

CREATE TABLE user_info (id INT ( 11 ) NOT NULL AUTO_INCREMENT,username VARCHAR ( 127 ) NOT…